GPU che progettano GPU grazie all’intelligenza artificiale: lo sta facendo NVIDIA

Bill Dally, chief scientist e vicepresidente senior per la ricerca di NVIDIA, ha illustrato durante la GTC 2022 le soluzioni di intelligenza artificiale che l’azienda sta sviluppando e che usa internamente per migliorare i suoi prodotti. Come riportato da HPC Wire, NVIDIA ha iniziato a usare l’IA per migliorare e velocizzare la progettazione delle proprie GPU.

“È naturale, come esperti di IA, che vorremmo prendere quell’IA e usarla per progettare chip migliori. Lo facciamo in un paio di modi diversi. Il primo e più ovvio è che possiamo prendere i tool CAD che abbiamo e incorporarvi l’IA”, spiega Dally. “Ad esempio, ne abbiamo uno che prende una mappa di dove viene utilizzata la potenza nelle nostre GPU e prevede fino a che punto scende la tensione di rete. Farlo con uno strumento CAD tradizionale richiede tre ore“, ha osservato Dally.

“Poiché è un processo ripetitivo, diventa molto problematico per noi. Quello che vorremmo fare invece è addestrare un modello di intelligenza artificiale per ottenere gli stessi dati; lo facciamo su un mucchio di progetti, e quindi possiamo sostanzialmente alimentare la mappa della potenza. Il tempo di inferenza risultante è di soli 3 secondi. Naturalmente, si tratta di 18 minuti se includi il tempo per l’estrazione di caratteristiche (feature extraction)”.

“Possiamo ottenere risultati molto velocemente. Invece di usare una rete neurale convoluzionale, utilizziamo una rete neurale a grafo per stimare la frequenza con cui commutano diversi nodi nel circuito, e come questo influisce sull’alimentazione dell’esempio precedente. Inoltre, siamo in grado di ottenere stime di potenza davvero accurate molto più rapidamente rispetto agli strumenti convenzionali e in una minuscola frazione di tempo”, ha affermato Dally.

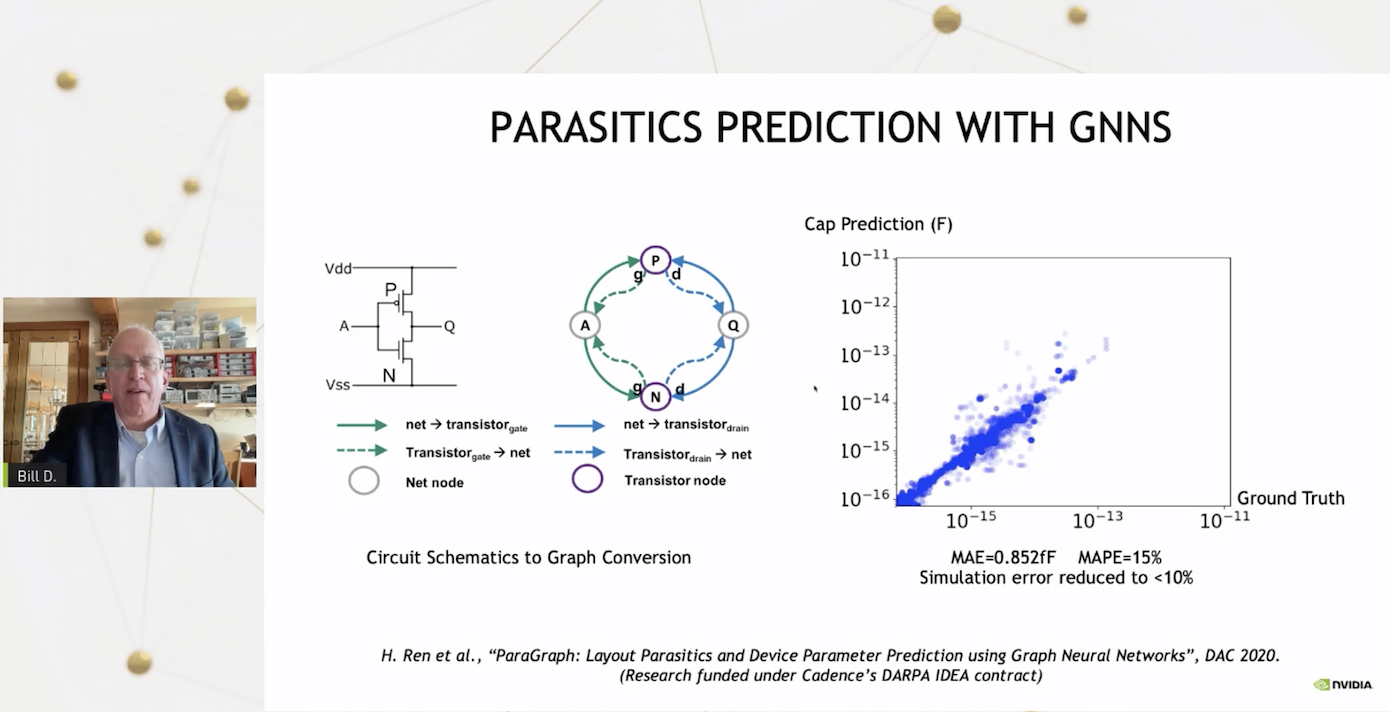

Il chieft scientist, ad esempio, sta lavorando per prevedere tramite reti neurali a grafi gli elementi parassiti di un circuito stampato. “In passato la progettazione di un circuito era un processo molto ripetitivo in cui si disegnava uno schema, proprio come questa immagine sopra con i due transistor. Ma non avresti saputo come si sarebbe comportato fino a quando un progettista di layout avrebbe preso quello schema e realizzato il layout, estratto gli elementi parassiti e solo allora potevi eseguire le simulazioni del circuito e scoprire che non stavi soddisfacendo alcune specifiche”.

Nel caso peggiore bisognava modificare lo schema molte volte e ripetere il processo, consumando un sacco di tempo e di energia. “Ora quello che possiamo fare è addestrare le reti neurali per prevedere quali saranno gli elementi parassiti senza dover realizzare il layout“. NVIDIA è riuscita a ottenere una previsione molto accurata degli elementi parassiti, il che velocizza un passaggio dello sviluppo di una GPU.

Un altro ambito in cui NVIDIA usa l’IA è per impedire la congestione delle piste, ovvero punti in cui “ci sono troppi fili che cercano di passare lungo una determinata area, una sorta di ingorgo per bit. Quello che possiamo fare è […] usare una rete neurale a grafo per prevedere dove si verificherà la congestione in modo abbastanza preciso”. Al momento la tecnologia non è perfetta, ma dà un’indicazione di massima su dove bisogna agire.

In casa NVIDIA però non usano l’IA solo per sottoporle un progetto realizzato da umani al fine di ottimizzarlo. Un altro ambito di ricerca è usare l’IA per progettare. Il primo sistema, chiamato NVCell, utilizza una combinazione di ricottura simulata e apprendimento per rinforzo per progettare la libreria di celle che serve, ad esempio, per far passare un progetto dal processo a 7 nanometri a quello a 5 nanometri. “Si tratta di molte migliaia di celle che devono essere riprogettate per il nuovo processo con un insieme molto complesso di regole di progettazione”, ha spiegato Dally.

“In pratica lo facciamo usando l’apprendimento per rinforzo per posizionare i transistor. Ma, cosa ancora più importante, dopo che sono stati posizionati, di solito ci sono un sacco di errori nelle regole di progettazione e il tutto diventa quasi come un videogioco, qualcosa in cui l’apprendimento per rinforzo è bravo. […] Correggendo questi errori con l’apprendimento per rinforzo, siamo in grado di completare fondamentalmente la progettazione delle nostre celle standard”.

In una prova, la soluzione adottata è stata in grado di realizzare correttamente il 92% della libreria di celle senza regole di progettazione o errori per quanto concerne regole elettriche. “Questo da una parte è un enorme risparmio di manodopera, dall’altra – in molti casi – otteniamo un design migliore“. Questo lavoro, svolto da 10 persone, le terrebbe occupate per buona parte dell’anno: “Ora possiamo farlo con un paio di GPU in funzione per alcuni giorni. Gli esseri umani possono lavorare su quell’8% delle celle che non sono state realizzate automaticamente”.

Fonte: http://feeds.hwupgrade.it/