NVIDIA Blackwell B100 fa già paura: prestazioni che stracciano H200 Hopper

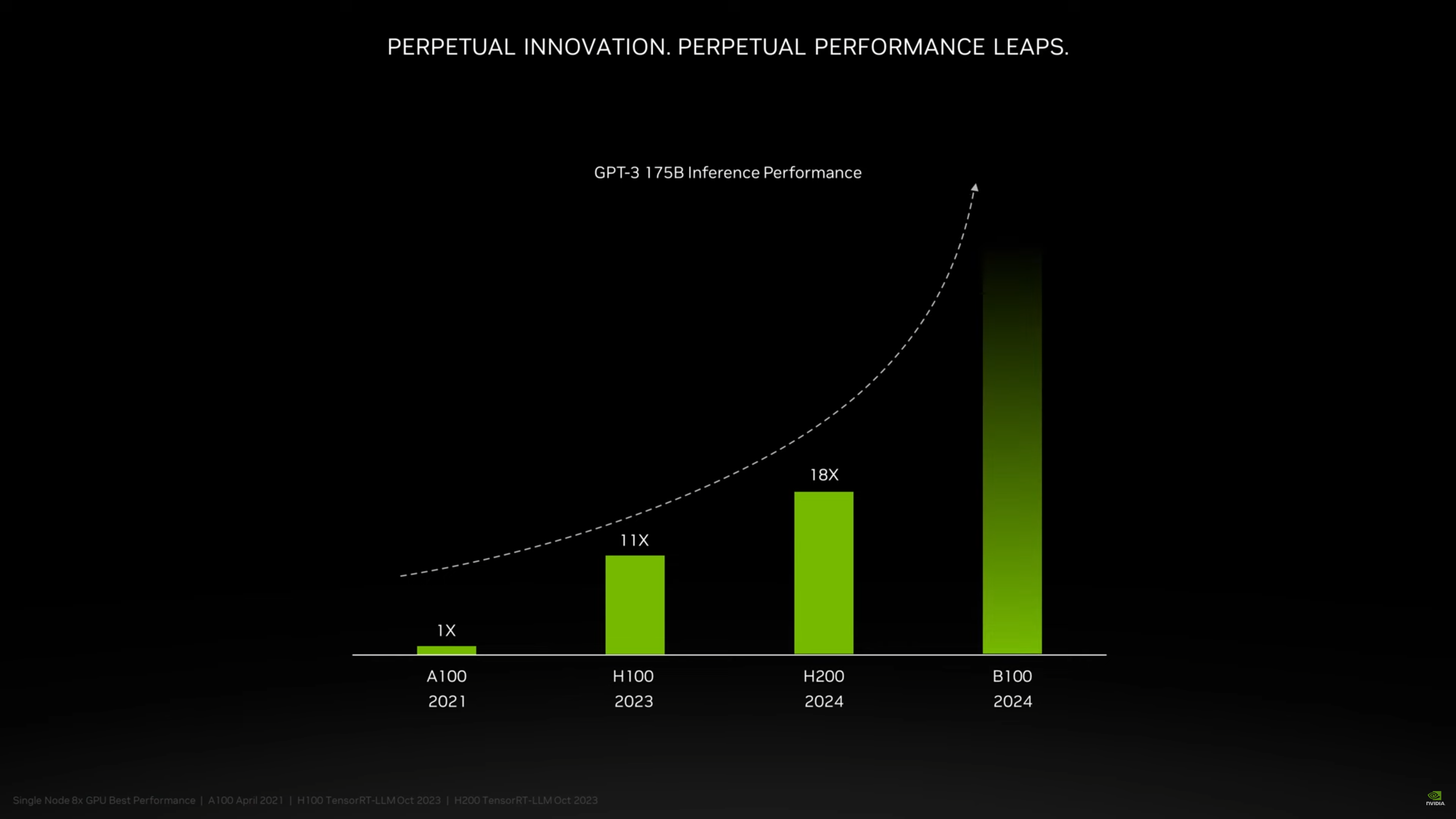

In occasione di una conferenza all’SC23 di Denver, NVIDIA ha svelato per la prima volta le prestazioni di Blackwell B100, GPU in arrivo nel 2024 che andrà a succedere alla generazione Hopper (H100 e H200).

In una breve anticipazione sotto forma di slide, NVIDIA ha mostrato che Blackwell B100 sarà in grado di bruciare la sua attuale soluzione di punta H200. Non c’è una scala per l’asse verticale, ma si può facilmente intuire che le prestazioni di inferenza con i modelli GPT-3 come GPT-3 175B (ribattezzato da vinci, 175 miliardi di parametri) saranno più che raddoppiate dalla nuova architettura. Ovviamente il dato è da prendere come una singola proiezione e non un valore generale.

Clicca per ingrandire

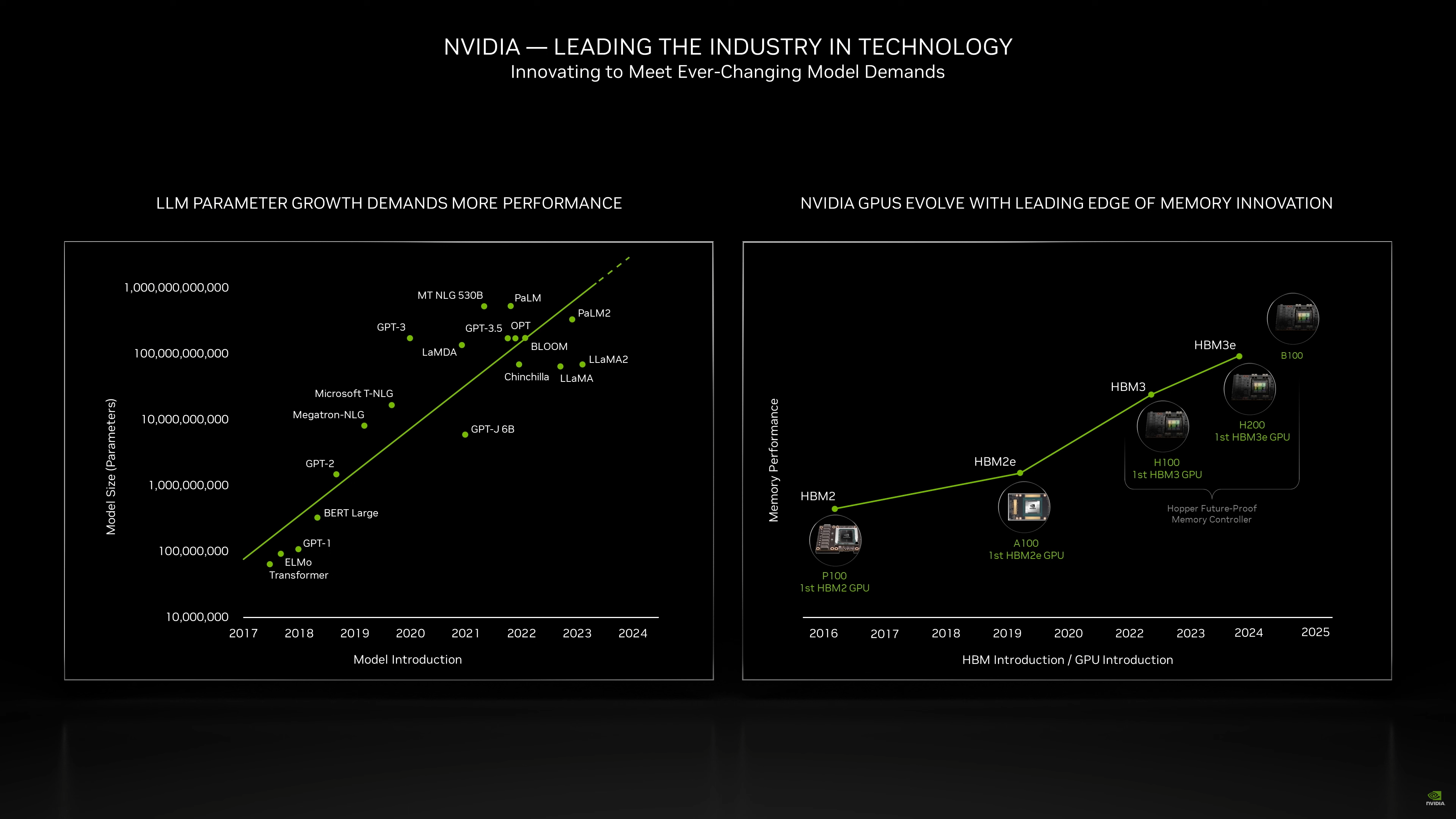

Secondo indiscrezioni, NVIDIA si avvarrà del processo produttivo a 3 nanometri di TSMC per realizzare Blackwell B100: è possibile che si tratti, inoltre, del primo progetto MCM (multi-chip module, più chip sul package che lavorano insieme) della società. Una seconda slide sembra lasciare intendere che B100 sarà accompagnato da memoria HBM3E, magari più veloce rispetto a quella implementata su H200.

Clicca per ingrandire

Recentemente la società statunitense ha annunciato il passaggio da una cadenza biennale a una annuale nello sviluppo di nuove architetture per il mondo dei datacenter.

NVIDIA: prima di B100, ecco H200 con 141 GB di memoria HBM3E

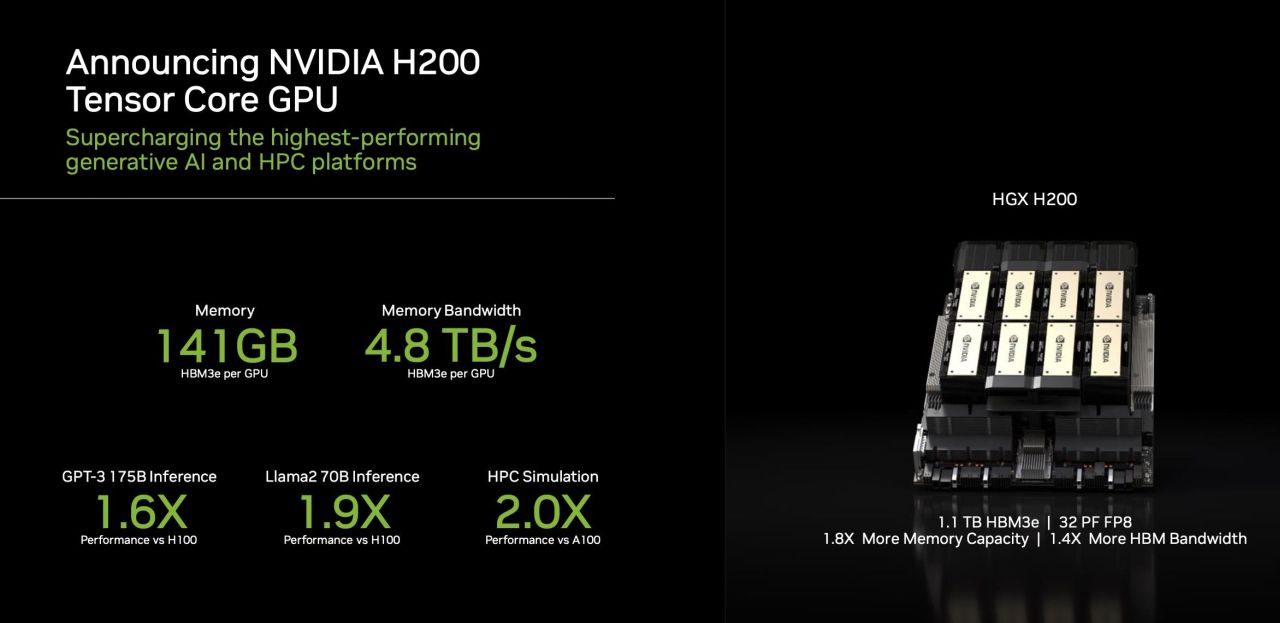

Ad agosto NVIDIA annunciò GH200 Grace Hopper Superchip, versione di Grace Hopper Superchip (CPU ARM + GPU Hopper) dotata di memoria HBM3E. In queste ore la società guidata da Jensen Huang ha rilanciato con H200, versione aggiornata con memoria HBM3E dell’acceleratore basato su GPU H100. Non solo, la capacità della memoria passa da 80 a 141 GB, con una bandwidth di 4,8 TB al secondo grazie a un bus a 6144 bit.

Clicca per ingrandire

Il numero 141 è particolare, e in effetti sulla scheda sono presenti fisicamente 144 GB per effetto di sei stack da 24 GB, ma NVIDIA ha deciso di tenersi del margine per qualche ragione, forse una questione di rese produttive.

Sebbene NVIDIA non sia entrata nei dettagli, non sembra che la GPU abbia subito mutamenti rispetto ad H200, quindi i miglioramenti prestazionali indicati dalla società devono essere ricollegati alla sola memoria. Il nuovo acceleratore sarà disponibile nel secondo trimestre 2024.

Clicca per ingrandire

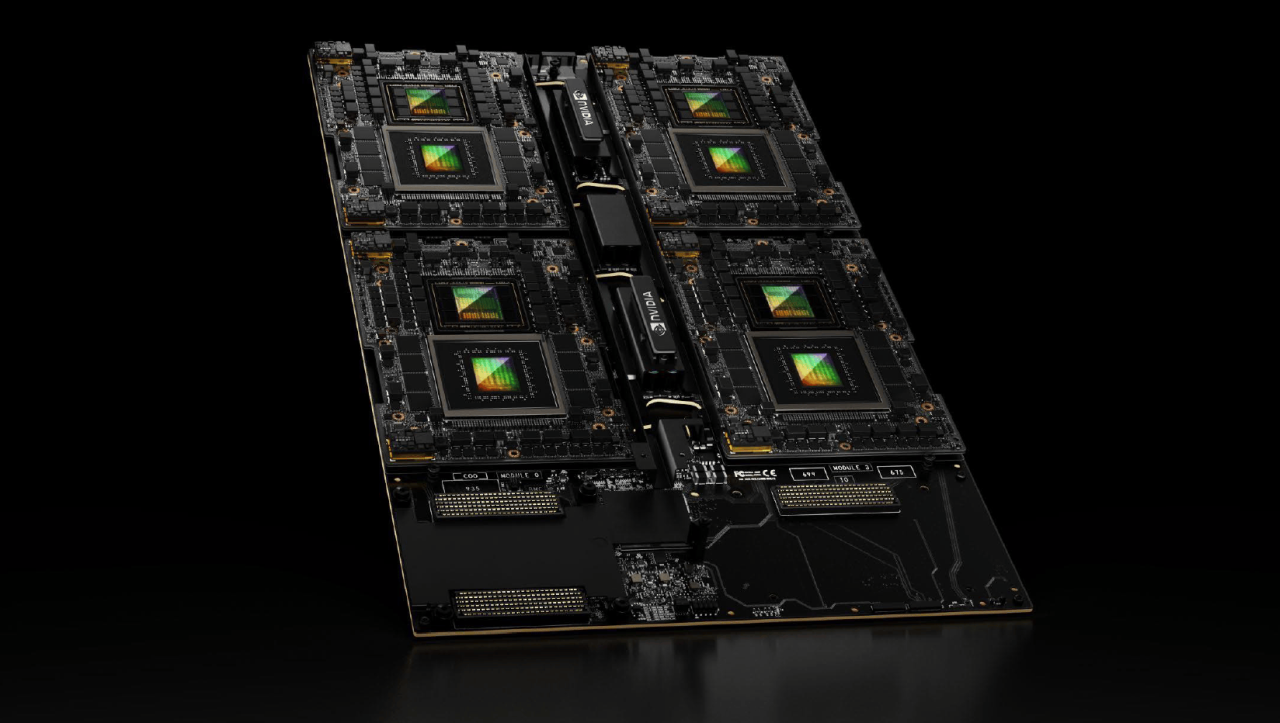

NVIDIA ha svelato anche HGX H200, ovvero un sistema con 8 soluzioni H200 in formato SMX, aggiornamento del preesistente HGX H100. Un’altra novità, infine, si chiama Quad GH200: come fa intuire il nome, si tratta di una soluzione che mette insieme 4 soluzioni GH200 Grace Hopper Superchip in parallelo, per un totale di 288 core ARM, 1920 GB di memoria LPDDR5X e 384 GB di memoria HBM3 (in questo caso non parliamo della versione aggiornata con HBM3E), per un totale di 2,3 TB di memoria. Tra le prime società a offrire questa soluzione troviamo, come riportato qui, HPE (HP Enterprise) con Cray EX2500.

Fonte: http://feeds.hwupgrade.it/